H Apple δηλώνει ότι καθυστερεί τη διάθεση των εργαλείων ανίχνευσης υλικού σεξουαλικής κακοποίησης παιδιών (CSAM) «για να βελτιωθούν» μετά από αντίδραση κριτικών. Τα χαρακτηριστικά περιλαμβάνουν ένα που αναλύει τις φωτογραφίες iCloud για γνωστό CSAM, το οποίο έχει προκαλέσει ανησυχία στους υποστηρικτές της ιδιωτικής ζωής.

«Τον περασμένο μήνα ανακοινώσαμε σχέδια για δυνατότητες που θα βοηθήσουν στην προστασία των παιδιών από τα “αρπακτικά ζώα” που χρησιμοποιούν εργαλεία επικοινωνίας για να τα στρατολογήσουν και να τα εκμεταλλευτούν και να περιορίσουν τη διάδοση υλικού σεξουαλικής κακοποίησης παιδιών», ανέφερε η Apple σε δήλωσή της. «Με βάση τα σχόλια των πελατών, ομάδες υπεράσπισης, ερευνητές και άλλοι, αποφασίσαμε να αφιερώσουμε επιπλέον χρόνο μέσα στους επόμενους μήνες για να συλλέξουμε πληροφορίες και να κάνουμε βελτιώσεις πριν κυκλοφορήσουμε αυτά τα εξαιρετικά σημαντικά χαρακτηριστικά ασφάλειας των παιδιών ».

Η Apple σχεδίασε να κυκλοφορήσει τα συστήματα ανίχνευσης CSAM ως μέρος των επερχόμενων ενημερώσεων λειτουργικού συστήματος, συγκεκριμένα iOS 15, iPadOS 15, watchOS 8 και macOS Monterey. Η εταιρεία αναμένεται να κυκλοφορήσει αυτές τις επόμενες εβδομάδες. Η Apple δεν μπήκε σε λεπτομέρειες σχετικά με τις βελτιώσεις που μπορεί να κάνει. Η Engadget επικοινώνησε με την εταιρεία για σχόλια.

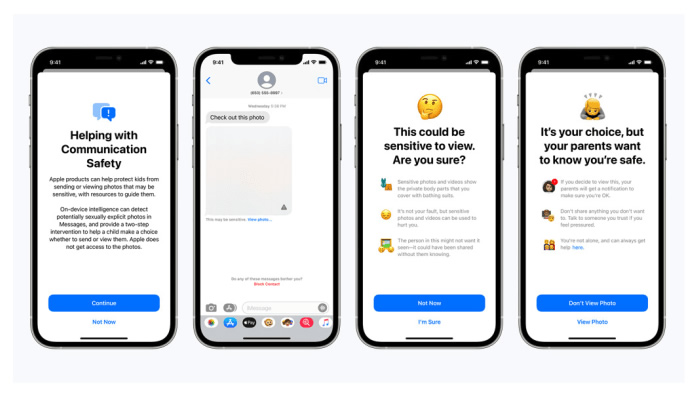

Οι προγραμματισμένες λειτουργίες περιλάμβαναν ένα για τα Μηνύματα, το οποίο θα ειδοποιούσε τα παιδιά και τους γονείς τους όταν η Apple διαπιστώσει ότι σεξουαλικά άσεμνες φωτογραφίες μοιράζονταν στην εφαρμογή χρησιμοποιώντας συστήματα μηχανικής εκμάθησης στη συσκευή. Τέτοιες εικόνες που αποστέλλονται στα παιδιά θα είναι θολές και θα περιλαμβάνουν προειδοποιήσεις. Το Siri και οι ενσωματωμένες λειτουργίες αναζήτησης σε iOS και macOS θα κατευθύνουν τους χρήστες σε κατάλληλους πόρους όταν κάποιος ρωτά πώς να αναφέρει το CSAM ή προσπαθεί να πραγματοποιήσει αναζητήσεις που σχετίζονται με το CSAM.

Το εργαλείο iCloud Photos είναι ίσως το πιο αμφιλεγόμενο από τα χαρακτηριστικά ανίχνευσης CSAM που ανακοίνωσε η Apple. Σχεδιάζει να χρησιμοποιήσει ένα σύστημα στη συσκευή για να αντιστοιχίσει φωτογραφίες με μια βάση δεδομένων γνωστών κατακερματισμών εικόνων CSAM (ένα είδος ψηφιακού αποτυπώματος για τέτοιες εικόνες) που διατηρείται από το Εθνικό Κέντρο για τα αγνοούμενα και εκμεταλλευόμενα παιδιά και άλλους οργανισμούς. Αυτή η ανάλυση υποτίθεται ότι πραγματοποιείται πριν από τη μεταφόρτωση μιας εικόνας στο iCloud Photos. Εάν το σύστημα ανίχνευσης του CSAM και των ανθρώπων επιβεβαίωναν το ταίριασμα, η Apple θα απενεργοποιούσε τον λογαριασμό του ατόμου και θα έστελνε μια αναφορά στο NCMEC.